クラウドサービスのニーズに応えるため、ネットワークは徐々にアンダーレイとオーバーレイに分割されつつあります。アンダーレイネットワークは、従来のデータセンターにおけるルーティングやスイッチングなどの物理機器であり、安定性を重視し、信頼性の高いネットワークデータ伝送機能を提供します。オーバーレイは、VXLANまたはGREプロトコルによるカプセル化を通じてサービスに近接したビジネスネットワークをアンダーレイ上にカプセル化し、ユーザーに使いやすいネットワークサービスを提供します。アンダーレイネットワークとオーバーレイネットワークは互いに関連しながらも分離されており、独立して進化することができます。

アンダーレイネットワークはネットワークの基盤です。アンダーレイネットワークが不安定であれば、ビジネスにSLAは適用されません。三層ネットワークアーキテクチャとファットツリーネットワークアーキテクチャを経て、データセンターネットワークアーキテクチャはスパインリーフアーキテクチャへと移行し、CLOSネットワークモデルの第三の適用を先導しました。

従来のデータセンターネットワークアーキテクチャ

3層構造

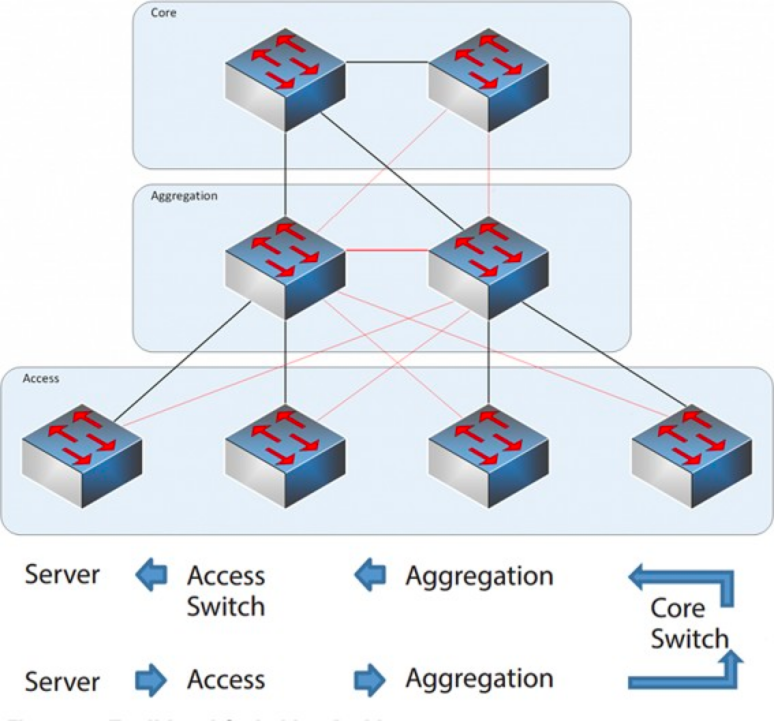

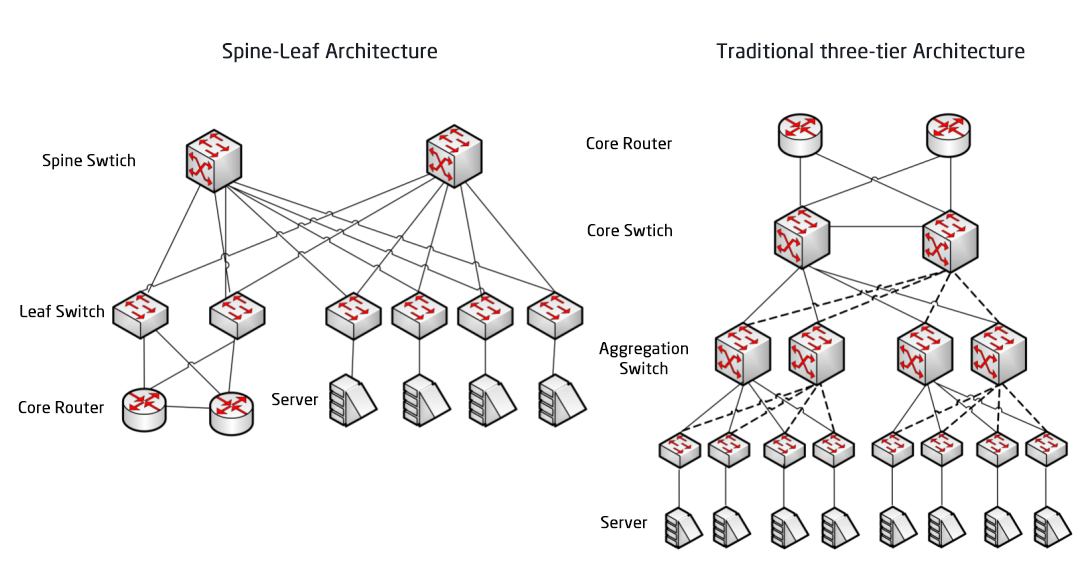

2004年から2007年にかけて、データセンターでは3層ネットワークアーキテクチャが広く普及しました。このアーキテクチャは、コア層(ネットワークの高速スイッチングバックボーン)、アグリゲーション層(ポリシーベースの接続を提供)、アクセス層(ワークステーションをネットワークに接続する層)の3つの層で構成されています。モデルは以下のとおりです。

3層ネットワークアーキテクチャ

コア レイヤー: コア スイッチは、データ センター内外へのパケットの高速転送、複数の集約レイヤーへの接続、通常はネットワーク全体にサービスを提供する耐障害性の高い L3 ルーティング ネットワークを提供します。

集約層: 集約スイッチはアクセス スイッチに接続し、ファイアウォール、SSL オフロード、侵入検知、ネットワーク分析などの他のサービスを提供します。

アクセス レイヤー: アクセス スイッチは通常、ラックの上部にあるため、ToR (Top of Rack) スイッチとも呼ばれ、物理的にサーバーに接続します。

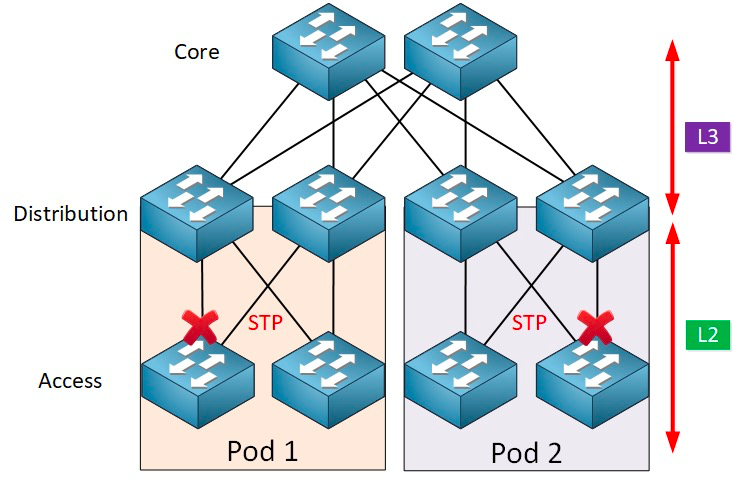

通常、アグリゲーションスイッチはL2ネットワークとL3ネットワークの境界点となります。L2ネットワークはアグリゲーションスイッチの下位にあり、L3ネットワークは上位にあります。アグリゲーションスイッチの各グループは、配信ポイント(POD)を管理し、各PODは独立したVLANネットワークです。

ネットワークループとスパニングツリープロトコル

ループの形成は、主に宛先パスの不明確さによる混乱が原因です。ユーザーがネットワークを構築する際には、信頼性を確保するために冗長デバイスや冗長リンクを使用することが多いため、必然的にループが形成されます。レイヤー2ネットワークは同一のブロードキャストドメイン内にあるため、ブロードキャストパケットはループ内で繰り返し送信され、ブロードキャストストームを形成します。ブロードキャストストームは、瞬く間にポートの閉塞や機器の麻痺を引き起こす可能性があります。したがって、ブロードキャストストームを防ぐには、ループの形成を防ぐ必要があります。

ループの形成を防ぎ、信頼性を確保するために、冗長デバイスと冗長リンクをバックアップデバイスとバックアップリンクに切り替えることのみが可能です。つまり、冗長デバイスのポートとリンクは通常時はブロックされ、データパケットの転送には参加しません。現在の転送デバイス、ポート、リンクに障害が発生し、ネットワークの輻輳が発生した場合のみ、冗長デバイスのポートとリンクが開かれ、ネットワークを正常な状態に復旧できます。この自動制御は、スパニングツリープロトコル(STP)によって実装されます。

スパニングツリープロトコルはアクセス層とシンク層の間で動作し、その中核を成すのは各STP対応ブリッジ上で実行されるスパニングツリーアルゴリズムです。このアルゴリズムは、冗長パスが存在する場合にブリッジングループを回避するよう特別に設計されています。STPはメッセージ転送に最適なデータパスを選択し、スパニングツリーに含まれないリンクを禁止します。これにより、任意の2つのネットワークノード間にはアクティブなパスが1つだけ残り、もう一方のアップリンクはブロックされます。

STPには多くの利点があります。シンプルでプラグアンドプレイであり、設定もほとんど必要ありません。各ポッド内のマシンは同じVLANに属しているため、サーバーはIPアドレスやゲートウェイを変更することなく、ポッド内で任意の場所に移動できます。

ただし、STPでは並列転送パスを使用できないため、VLAN内の冗長パスは常に無効になります。STPの欠点:

1. トポロジの収束が遅い。ネットワークトポロジが変更されると、スパニングツリープロトコルはトポロジの収束を完了するのに50~52秒かかります。

2. 負荷分散機能を提供できません。ネットワークにループが発生した場合、スパニングツリープロトコルはループをブロックするだけなので、リンクはデータパケットを転送できず、ネットワークリソースが浪費されます。

仮想化と東西トラフィックの課題

2010年以降、コンピューティングリソースとストレージリソースの利用率を向上させるため、データセンターは仮想化技術を採用し始め、ネットワーク上に多数の仮想マシンが登場し始めました。仮想化技術は、1台のサーバーを複数の論理サーバーに変換します。各VMは独立して動作し、独自のOS、アプリケーション、独立したMACアドレスとIPアドレスを持ち、サーバー内の仮想スイッチ(vSwitch)を介して外部エンティティに接続します。

仮想化には、仮想マシンのライブマイグレーションという、仮想マシン上のサービスの通常の動作を維持しながら、仮想マシンのシステムをある物理サーバーから別の物理サーバーへ移行する機能という付随要件があります。このプロセスはエンドユーザーに影響を与えないため、管理者はユーザーの通常の使用に影響を与えることなく、サーバーリソースを柔軟に割り当てたり、物理サーバーの修理やアップグレードを行ったりすることができます。

移行中にサービスが中断されないようにするためには、仮想マシンのIPアドレスが変更されないだけでなく、仮想マシンの実行状態(TCPセッション状態など)も移行中に維持される必要があります。そのため、仮想マシンの動的移行は、同じレイヤー2ドメイン内でのみ実行でき、レイヤー2ドメインをまたがる移行は実行できません。そのため、アクセスレイヤーからコアレイヤーにかけて、より大規模なレイヤー2ドメインが必要になります。

従来の大規模レイヤ2ネットワークアーキテクチャにおけるL2とL3の分岐点はコアスイッチにあり、コアスイッチ以下のデータセンターは完全なブロードキャストドメイン、つまりL2ネットワークです。これにより、デバイスの配置やロケーションの移動の自由度が実現され、IPやゲートウェイの設定を変更する必要がなくなります。異なるL2ネットワーク(VLAN)はコアスイッチを介してルーティングされます。しかし、このアーキテクチャのコアスイッチは膨大なMACアドレスとARPテーブルを管理する必要があり、コアスイッチの能力に対する要求は高くなります。さらに、アクセススイッチ(TOR)もネットワーク全体の規模を制限します。これらは最終的にネットワークの規模、ネットワークの拡張性と弾力性を制限し、3層のスケジューリングにわたる遅延の問題は、将来のビジネスニーズを満たすことができません。

一方、仮想化技術によってもたらされる東西トラフィックは、従来の3層ネットワークにも課題をもたらします。データセンターのトラフィックは、大きく分けて以下のカテゴリーに分類できます。

南北交通:データセンター外部のクライアントとデータセンター サーバー間のトラフィック、またはデータセンター サーバーからインターネットへのトラフィック。

東西交通:データセンター内のサーバー間のトラフィック、およびデータセンター間の災害復旧、プライベート クラウドとパブリック クラウド間の通信など、異なるデータセンター間のトラフィック。

仮想化技術の導入により、アプリケーションの展開はますます分散化され、その「副作用」として東西トラフィックが増加しています。

従来の 3 層アーキテクチャは、通常、南北トラフィック向けに設計されています。東西トラフィックには使用できますが、最終的には要求どおりに機能しない可能性があります。

従来の3層アーキテクチャとスパインリーフアーキテクチャ

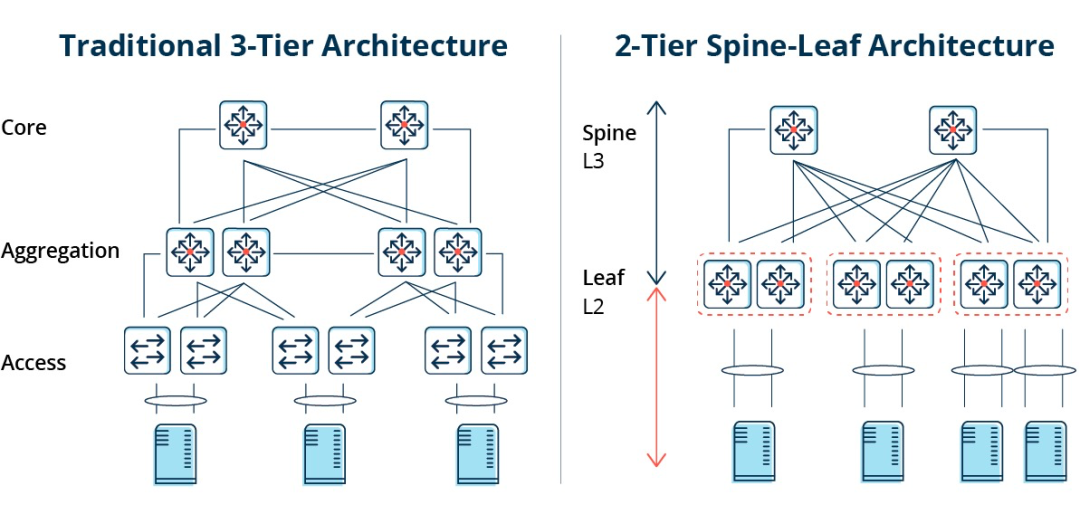

3層アーキテクチャでは、East-Westトラフィックはアグリゲーション層とコア層のデバイスを経由して転送される必要があります。そのため、多くのノードを不必要に通過することになります。(サーバー -> アクセス -> アグリゲーション -> コアスイッチ -> アグリゲーション -> アクセススイッチ -> サーバー)

したがって、従来の 3 層ネットワーク アーキテクチャを介して大量の東西トラフィックが実行される場合、同じスイッチ ポートに接続されたデバイスが帯域幅を競合し、エンド ユーザーの応答時間が遅くなる可能性があります。

従来の3層ネットワークアーキテクチャの欠点

従来の 3 層ネットワーク アーキテクチャには多くの欠点があることがわかります。

帯域幅の無駄:ループを防ぐために、STP プロトコルは通常、集約層とアクセス層の間で実行されます。これにより、アクセス スイッチの 1 つのアップリンクのみが実際にトラフィックを伝送され、他のアップリンクはブロックされるため、帯域幅が無駄になります。

大規模ネットワーク配置の難しさ:ネットワーク規模の拡大に伴い、データセンターはさまざまな地理的な場所に分散され、仮想マシンを任意の場所に作成して移行する必要があり、IP アドレスやゲートウェイなどのネットワーク属性は変更されないため、ファット レイヤー 2 のサポートが必要になります。従来の構造では、移行は実行できません。

東西交通の不足:3層ネットワークアーキテクチャは主に南北トラフィック向けに設計されていますが、東西トラフィックもサポートしています。しかし、欠点は明らかです。東西トラフィックが大きくなると、アグリゲーション層とコア層のスイッチへの負荷が大幅に増加し、ネットワークのサイズとパフォーマンスはアグリゲーション層とコア層に限定されてしまいます。

これにより、企業はコストとスケーラビリティのジレンマに陥ります。大規模で高性能なネットワークをサポートするには、多数のコンバージェンス層およびコア層の機器が必要であり、企業にとって高コストとなるだけでなく、ネットワーク構築時に事前にネットワーク計画を立てる必要があります。ネットワーク規模が小さい場合はリソースの無駄が生じ、ネットワーク規模が拡大し続けると拡張が困難になります。

スパインリーフ型ネットワークアーキテクチャ

スパインリーフネットワークアーキテクチャとは何ですか?

上記の問題に対して、新しいデータ センター設計であるスパイン リーフ ネットワーク アーキテクチャが登場しました。これはリーフ リッジ ネットワークと呼ばれています。

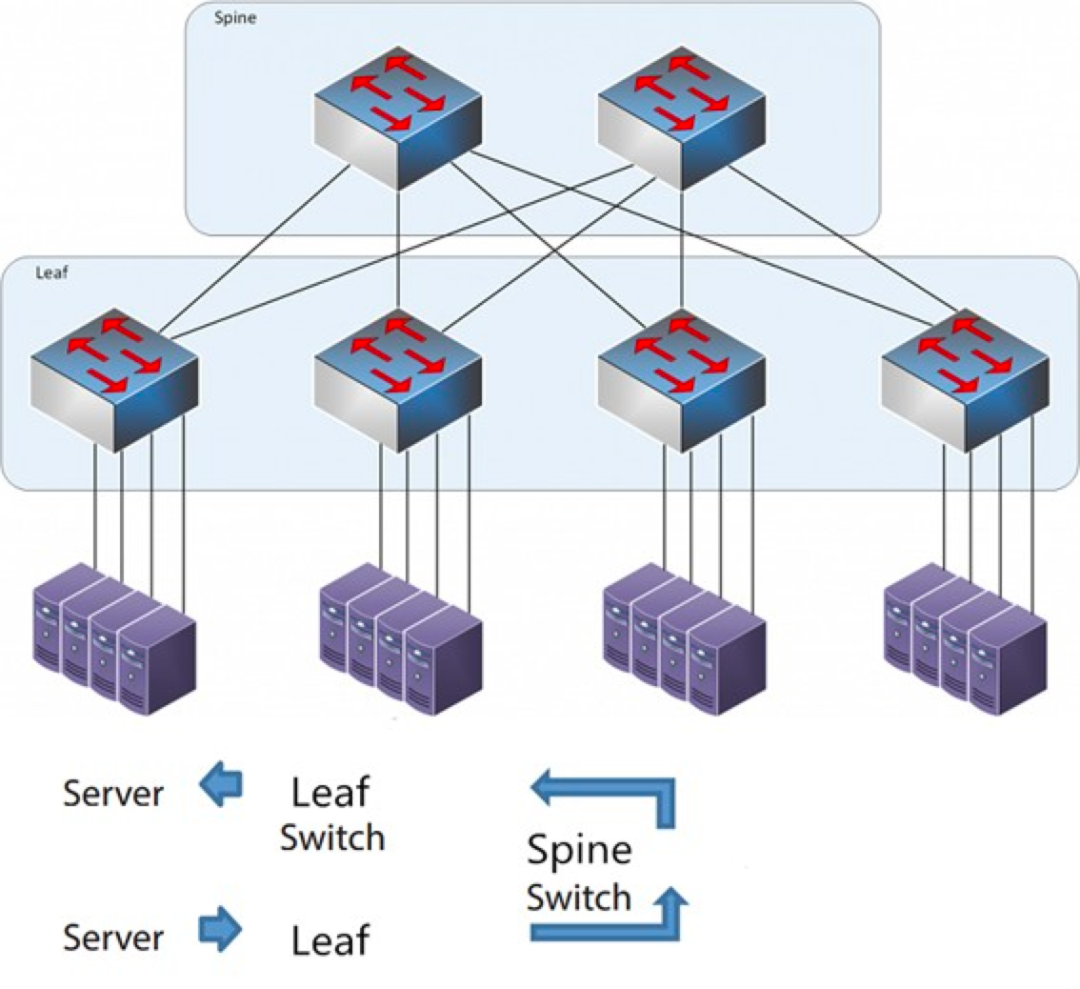

名前が示すように、アーキテクチャにはスパイン レイヤーとリーフ レイヤーがあり、スパイン スイッチとリーフ スイッチが含まれます。

スパインリーフアーキテクチャ

各リーフ スイッチは、互いに直接接続されていないすべてのリッジ スイッチに接続され、フルメッシュ トポロジを形成します。

スパイン・リーフ型では、あるサーバーから別のサーバーへの接続は、同じ数のデバイス(サーバー -> リーフ -> スパインスイッチ -> リーフスイッチ -> サーバー)を通過するため、予測可能なレイテンシが確保されます。パケットは、宛先に到達するまでに、1つのスパインともう1つのリーフを通過するだけで済むためです。

スパインリーフはどのように機能しますか?

リーフスイッチ:従来の3層アーキテクチャにおけるアクセススイッチに相当し、TOR(Top Of Rack)として物理サーバーに直接接続します。アクセススイッチとの違いは、L2/L3ネットワークの境界点がリーフスイッチ上に配置されていることです。リーフスイッチは3層ネットワークの上位にあり、独立したL2ブロードキャストドメインの下位にあるため、大規模な2層ネットワークのBUM問題を解決します。2つのリーフサーバーが通信する必要がある場合は、L3ルーティングを使用し、スパインスイッチを介して転送する必要があります。

スパインスイッチ:コアスイッチに相当します。ECMP(Equal Cost Multi Path)は、スパインスイッチとリーフスイッチ間の複数のパスを動的に選択するために使用されます。違いは、スパインがリーフスイッチに耐障害性の高いL3ルーティングネットワークを提供するだけになったことです。これにより、データセンターのNorth-Southトラフィックは、直接ルーティングされるのではなく、スパインスイッチからルーティングされます。North-Southトラフィックは、エッジスイッチからリーフスイッチと並行してWANルーターにルーティングされます。

スパイン/リーフ型ネットワークアーキテクチャと従来の3層ネットワークアーキテクチャの比較

スパインリーフの利点

フラット:フラット設計により、サーバー間の通信パスが短縮され、レイテンシが低減されるため、アプリケーションとサービスのパフォーマンスが大幅に向上します。

優れたスケーラビリティ:帯域幅が不足している場合は、リッジスイッチの数を増やすことで水平方向に帯域幅を拡張できます。サーバー数が増加し、ポート密度が不足している場合は、リーフスイッチを追加できます。

コスト削減:リーフノードまたはリッジノードから出るノースバウンドおよびサウスバウンドのトラフィック。イーストウェストフローは複数のパスに分散されます。このように、リーフリッジネットワークでは高価なモジュラースイッチを必要とせず、固定構成のスイッチを使用できるため、コストを削減できます。

低遅延と輻輳回避:リーフリッジ型ネットワークにおけるデータフローは、送信元と宛先に関わらず、ネットワーク全体で同じホップ数で接続され、任意の2つのサーバーはリーフ -> スパイン -> リーフの3ホップで到達可能です。これにより、より直接的なトラフィックパスが確立され、パフォーマンスが向上し、ボトルネックが軽減されます。

高いセキュリティと可用性:STPプロトコルは従来の3層ネットワークアーキテクチャで使用されており、デバイスに障害が発生すると再収束が発生し、ネットワークパフォーマンスに影響を与えたり、場合によっては障害が発生することがあります。リーフリッジアーキテクチャでは、デバイスに障害が発生しても再収束の必要がなく、トラフィックは他の正常なパスを通過し続けます。ネットワーク接続性は影響を受けず、帯域幅は1パス分減少するだけで、パフォーマンスへの影響は最小限に抑えられます。

ECMPによる負荷分散は、SDNなどの集中型ネットワーク管理プラットフォームが使用されている環境に最適です。SDNは、ブロックやリンク障害発生時のトラフィックの設定、管理、再ルーティングを簡素化するため、インテリジェントな負荷分散フルメッシュトポロジは比較的簡単に設定および管理できます。

ただし、スパイン/リーフ アーキテクチャにはいくつかの制限があります。

欠点の一つは、スイッチの数が増えることでネットワークの規模が大きくなることです。リーフリッジ型ネットワークアーキテクチャのデータセンターでは、クライアント数に比例してスイッチとネットワーク機器を増やす必要があります。ホスト数が増加すると、リッジスイッチへのアップリンクに多数のリーフスイッチが必要になります。

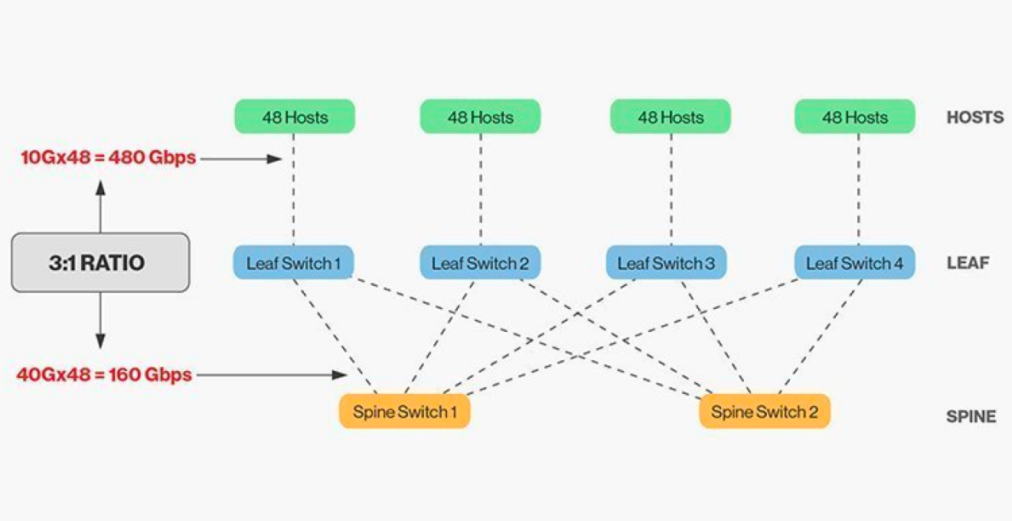

リッジ スイッチとリーフ スイッチを直接相互接続するにはマッチングが必要であり、一般に、リーフ スイッチとリッジ スイッチ間の適切な帯域幅比は 3:1 を超えることはできません。

例えば、リーフスイッチに10Gbpsのクライアントが48台あり、合計ポート容量が480Gb/sであるとします。各リーフスイッチの4つの40Gアップリンクポートを40Gリッジスイッチに接続すると、アップリンク容量は160Gb/sになります。比率は480:160、つまり3:1です。データセンターのアップリンクは通常40Gまたは100Gで、40G(Nx 40G)から100G(Nx 100G)へと徐々に移行できます。ポートリンクをブロックしないように、アップリンクは常にダウンリンクよりも高速に動作させる必要があることに注意することが重要です。

スパインリーフ型ネットワークには明確な配線要件があります。各リーフノードを各スパインスイッチに接続する必要があるため、より多くの銅線または光ファイバーケーブルを敷設する必要があります。相互接続距離が長くなるとコストが増加します。相互接続されたスイッチ間の距離に応じて、スパインリーフ型アーキテクチャに必要なハイエンド光モジュールの数は、従来の3層アーキテクチャの数十倍にもなり、全体的な導入コストが増加します。しかし、これは光モジュール市場の成長、特に100Gや400Gなどの高速光モジュールの成長につながっています。

投稿日時: 2026年1月26日